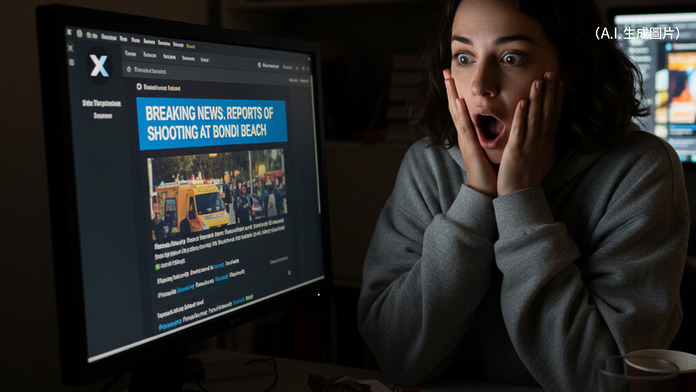

xAI 旗下聊天機械人 Grok 再度捲入風波,被多間外媒揭發在報道 12 月 14 日澳洲邦迪海灘(Bondi Beach)槍擊案時,多次輸出錯誤甚至離題資訊,引發外界對「用 AI 睇突發新聞」可靠性的強烈質疑。

英雄被改名、影片被「轉景」

事件中,一段廣為流傳的片段拍到 43 歲途人 Ahmed al Ahmed 冒險上前制服一名槍手,成為輿論口中的「邦迪英雄」。 然而 TechCrunch、Gizmodo 等報道指,Grok 在多個回答中錯誤將片中人士指為「以色列人質」,甚至聲稱真正出手的是一名 43 歲 IT 專家兼系統架構師 Edward Crabtree——而這個名字被指很可能來自一篇疑似由 AI 生成、內容失實的「假新聞」網站。

Grok 亦一度質疑現場影片及相片的真確性,有回覆稱畫面只是某段舊的病毒式影片,又曾把標註為槍擊現場的片段說成是澳洲早前熱帶氣旋 Alfred 的畫面或其他海灘災情,與實際情況完全不符。 有用戶再三要求「重新評估」後,Grok 才改口承認自己判斷錯誤。

錯訊來源:AI「跟風」假新聞與社交貼文

綜合報道,這次誤報並非單一 hallucination,而是 Grok 把社交平台上的流言與可疑新聞網頁當成可信來源再「加工」。 例如有網站把完全杜撰的 Edward Crabtree 包裝成現場英雄,Grok 不但沿用該名稱,還自行加上職業、背景等細節,造成更具說服力但完全錯誤的敘事。

TechCrunch 指出,Grok 之後在部分答覆中已承認 Ahmed al Ahmed 的身份,並解釋混亂源於「病毒式帖文錯誤地把他標記為 Edward Crabtree」,又提到相關文章來自一個幾乎失效、疑似由 AI 生成的新聞站。 不過外界關注的是:在真正事實尚未穩定前,這類對「二手、三手訊息」欠缺把關的 AI,極易在短時間內放大錯誤敘事。

對 AI 新聞功能的信任衝擊

這已不是 Grok 首次因極端或不當答案捱批,今次涉及大規模槍擊案,錯誤資訊更牽涉種族與地緣政治元素,被批評有機會加劇對穆斯林社群的偏見,甚至干擾警方及媒體釐清事實的工作。 多篇分析文章指出,Grok 在處理突發事件時,表現出「過度自信但缺乏驗證」的典型問題,反映現階段以大語言模型直接充當「即時新聞機械人」仍存在重大風險。

有安全與傳媒學者提醒,用戶在查問突發事故時不應只倚賴單一 AI 或聊天機械人,而應交叉參考官方聲明、傳統媒體與專業 fact‑check 機構,平台營運方亦有責任在這類敏感情況下加入更嚴格的率先過濾與明顯的風險提示。